Prof. Ben-Israel: „Wir sollten intelligenten Maschinen eher vertrauen als Menschen“

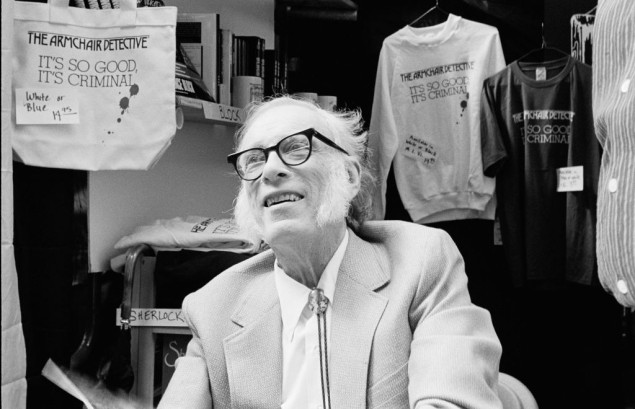

Prof. Isaac Ben-Israel (74) entwickelt zurzeit einen Plan, um Israel zu einem weltweit führenden Land in Künstlicher Intelligenz (KI) zu machen. Im eXXpress-Interview erläutert er, warum Maschinen den Menschen vorläufig nicht ersetzen können, warum aber Quantencomputer einen freien Willen haben werden. (Im ersten Interview-Teil erläuterte Ben-Israel die Cyber-Strategie Israels.)

Prof. Isaac Ben-Israel ist einer der führenden Experten Israels für Cyber, Weltraum und IT-Sicherheit.

Prof. Isaac Ben-Israel ist einer der führenden Experten Israels für Cyber, Weltraum und IT-Sicherheit.

Drohnen, die künstliche Intelligenz (KI) nutzen, werden im Ukraine-Krieg zunehmend eingesetzt. Sollten wir künftig mit Terminatoren rechnen, die in den Krieg ziehen und an unserer Stelle Entscheidungen treffen?

Alles ist möglich, aber ich glaube nicht, dass KI in den kommenden Jahren eine große Rolle bei der Ersetzung menschlicher Entscheidungen spielen wird. Maschinen können darauf trainiert werden, bestimmte Entscheidungen anstelle von Menschen zu treffen. Allerdings ist gerade der militärische Bereich einer der schwierigsten, es sei denn, wir sprechen von so einfachen Dingen wie Navigation. Wir navigieren mit Google Maps und fragen keinen Menschen mehr, in welcher Richtung wir etwas finden. Man kann auch moderne Technologie und KI dafür einsetzen, z. B. für die Navigation von unbemannten Luftfahrzeugen, Raketen usw.

Wesentlich komplizierter ist die Situation bei Entscheidungsfindung. Auf einem echten Schlachtfeld muss man die Ziele identifizieren, die sich normalerweise bewegen. Für gewöhnlich stützt man sich dabei auf verschiedene Informationen und vergleicht viele Daten, zum Beispiel aus Luftaufnahmen und Lauschangriffen. Erst dann kommt man zum Schluss, welches Ziel wichtig ist und angegriffen werden sollte.

KI-Algorithmen können diesen Entscheidungsprozess verkürzen. Das ist ein wichtiger Faktor auf dem Schlachtfeld. Aber sie treffen nicht die Entscheidung, welches Ziel angegriffen werden soll, denn das ist eine sehr komplexe Aufgabe. Es wird noch viele Jahre dauern, bis KI-Algorithmen diese Aufgabe übernehmen können. Jede Situation hat ihre eigenen, einzigartigen Probleme und unterschiedliche Prioritäten. Was gestern wichtig war, ist es heute nicht mehr. Das ist mit Maschinen nicht so einfach zu bewerkstelligen.

„Wir vertrauen Menschen, weil wir keine Alternative haben“

Wird man im Alltag künftig öfter Intelligente Maschinen einsetzen und ihnen vertrauen?

Wenn Sie mich fragen: Menschen sollten Maschinen mehr vertrauen als Menschen. Auch Menschen sind intelligente Maschinen. Der größte Schaden in der Geschichte wurde von Menschen angerichtet. Wir vertrauen anderen Menschen, weil wir keine Alternative haben. Schließlich handeln wir als Gesellschaft. Fast in jedem Moment vertrauen wir jemandem oder etwas, das nicht so vertrauenswürdig ist. Am Ende des Tages wird es mit Maschinen genauso sein.

ChatGPT wird Schülern und Studenten helfen – aber nur bedingt

Werden KI-Programme wie Chat-GPT in Zukunft Hausaufgaben und Artikel schreiben?

Nun, ich bin seit Jahren Universitätsprofessor. Ich weiß, dass meine Studenten Google benutzen, um nach Informationen zu einem Thema zu suchen, über das sie schreiben. ChatGPT hilft ihnen dabei, dies in schönerer Sprache zu tun. So ist das Leben. Natürlich wollen wir, dass ein Student in einer Arbeit zeigt, dass er gut aufgepasst hat und alle Fakten kennt. Aber das ist nicht mehr immer notwendig. Auch ich google zuerst im Internet, wenn mich jemand nach einer fundierten Antwort fragt.

Deshalb muss man den Schülern Fragen stellen, die auf das Verständnis abzielen. ChatGPT weiß, wie man Dinge ausdrückt, aber es versteht sie nicht wirklich, auch nicht besser als ein normaler Mensch. ChatGPT wird bei bestimmten Fragen versagen. Eine der Konsequenzen könnte sein, andere Aufgaben an Universitäten und Schulen zu stellen.

Was man übrigens nicht vergessen sollte: Sie können das ChatGPT-Programm nur nutzen, weil das US-Unternehmen OpenAI es Ihnen erlaubt. Dabei kommuniziert Ihr Computer (oder Smartphone) mit einem anderen, einer riesigen Maschine, die eine enorme Menge an Energie verbraucht. Wenn das Unternehmen die Anwendung schließt, haben Sie kein ChatGPT mehr. Wir neigen dazu, das zu vergessen, weil wir denken, dass sich ChatGPT hier in unserem Telefon befindet, während es in Wahrheit nur eine Kommunikationsverbindung zu etwas ist, das OpenAI gehört.

Den künftigen Schaden von KI können wir nur minimieren, nicht verhindern

Die EU plant bereits Vorschriften, um möglichen Gefahren von KI vorzubeugen. Ist das der richtige Ansatz?

Wir leben seit mindestens 250.000 Jahren mit KI – diesem Homo Sapiens. Wir tun viel, um die Probleme, die diese intelligenten Maschinen mit sich bringen, zu verringern, zum Beispiel in der Erziehung: Wir bringen Kindern bei, sich zu benehmen, die Zehn Gebote zu befolgen – was sie nicht immer tun. Außerdem haben wir ein Strafverfolgungssystem. Dennoch gibt es keinen einzigen Menschen auf der Welt, bei dem wir sicherstellen können, dass er in Zukunft keine Gefahr mehr darstellt. Wir können die Gefahr nicht beseitigen, sondern nur auf ein bestimmtes Maß reduzieren. So sollten wir auch bei KI vorgehen.

Absolute Sicherheit kann es nicht geben, denn mit KI meinen wir Maschinen, die aus ihren eigenen Erfahrungen lernen und ihr Verhalten ändern können. Das kann nicht mehr vom Programmierer und vom Hersteller der Maschine kontrolliert werden. Daher können wir nicht wirklich wissen, was passieren wird.

Stellen Sie sich vor, Sie bräuchten eine staatliche Lizenz, um Kinder zu bekommen und zu erziehen – es sei denn, Sie beweisen vorher, dass das Kind, das noch nicht lebt, künftig keinen Schaden anrichten wird. Niemand würde mehr Kinder zur Welt bringen. Wir bringen Kinder zur Welt, nehmen aber die Risiken ernst, und sorgen etwa über Bildung dafür, dass sie kein schlechter Mensch werden.

Das Gleiche gilt für KI. Wir brauchen Regulierung. Allerdings sollten wir die Dinge nicht in dem Maße einschränken, dass man vorher beweisen muss, dass sie keinen Schaden anrichten. Dann würde nichts mehr hergestellt werden. Wir sollten bestimmte Vorschriften erlassen, die das Ausmaß des Schadens, der durch KI entstehen kann, verringern, im Wissen darum, dass er nie auf null sinken wird. Auch Kriminalität können wir nur reduzieren, aber nicht abschaffen

„Nicht vollständig bestimmte Situationen sind das Merkmal der Natur“

Worin unterscheiden sich heutige Intelligente Maschinen von uns Menschen?

Wir bestehen im Gegensatz zu Computern aus viel komplexeren biologischen Molekülen, weshalb wir auch viel komplexere Maschinen sind. Ein weiterer Unterschied ist aber ein prinzipieller: Vermutlich sind wir Menschen Quantenmaschinen, keine binären Maschinen. Wir beschäftigen uns mit Situationen, die weder Null noch Eins sind. Wir leben erfolgreich mit nicht vollständig bestimmten Situationen. Das ist ein Merkmal der Natur, denn die Natur verhält sich gemäß der Quantenmechanik und nicht gemäß der binären Mathematik oder Logik. Doch heutige Maschinen haben es nur mit Nullen und Einsen zu tun.

Man arbeitet bereits an Quantenmaschinen und eines Tages werden wir künstliche Quantenintelligenz – Algorithmen von Quantencomputern – haben. Dann wird es im Prinzip keinen Unterschied zu uns geben, weil wir auch Maschinen sind und wissen, wie man neue – Kinder – herstellt und das kann ebenfalls höchst unvorhersehbar sein.

Weil man auch Menschen nicht immer vertrauen kann, gibt es die Demokratie

Politiker würden künftig dem Rat von KI vertrauen, selbst wenn sie zuvor zu anderen Schlussfolgerungen gelangt sind?

Wir wissen auch bei Menschen nicht, ob wir ihnen vertrauen sollen. Das ist auch ein Grundgedanke der Demokratie. Deshalb stimmen wir ab und beobachten, wie sich Regierungspolitiker verhalten. Wenn sie anderes tun, als wir es erwartet haben, können wir nach vier, fünf Jahren andere wählen. All das liegt daran, dass wir von vornherein nicht wissen können, was passieren wird.

Bei Quantencomputern sprechen wir von riesigen Maschinen, die enorme Mengen an Energie verbrauchen. Mit zahlreichen Fragen wie dem Energieverbrauch haben wir noch nicht einmal begonnen, uns zu befassen. Es wird also noch lange dauern, bis es soweit ist.

„Ich denke, dass wir im Prinzip Maschinen sind“

Israel will nun mehr in KI investieren und eine Supermacht werden. Wird es sich auf Quantencomputer konzentrieren?

Das wird ein wesentlicher Teil davon sein. Wirkliche Intelligenz entsteht nur in Auseinandersetzung mit Situationen, die in gewisser Weise zweideutig sind. Die reale Welt ist wie gesagt nicht binär ist. Situationen können nicht nur mit Nullen und Einsen dargestellt werden. Manchmal muss man sich entscheiden und gemäß der höchsten Wahrscheinlichkeit auswählen. Wenn Sie also wirklich führend in der KI-Technologie sein wollen, ist Quantencomputing ein wesentlicher Bestandteil davon.

Sie haben auch Philosophie studiert. Was macht den Menschen aus und warum kann eine intelligente Maschine alles tun, was der Mensch tut?

„Was ist der Mensch?“ war die Hauptfrage von Immanuel Kant. Seine Antwort war kompliziert. Er gab sie in seinen drei Kritiken. Dazu gehören die reine Vernunft – das, was wir heute Intelligenz nennen –, die praktische Vernunft, bei der es um moralische Werte geht, und das Urteilsvermögen, das wir heute vielleicht als Augenmaß bezeichnen würden. All dies kann von Maschinen nachgeahmt werden. Deshalb denke ich, dass wir im Prinzip Maschinen sind.

Sie schließen also nicht aus, dass intelligente Maschinen in Zukunft eine Ethik brauchen, weil sie handeln?

Ich schließe es nicht nur nicht aus, sondern denke, dass es notwendig sein wird, wenn man wirklich will, dass sich diese Maschinen entsprechend verhalten. Die Ethik sollte ihnen einprogrammiert werden. Übrigens hat das der Science-Fiction-Autor Isaac Asimov schon vor 90 Jahren in seinen Büchern über Roboter behandelt. In ihnen gab es drei Regeln für Roboter. Die erste davon war, niemals Menschen zu schaden, weder durch Handeln noch durch Unterlassen.

„Nur in einer Welt mit unbestimmten Situationen gibt es einen freien Willen“

Denken Sie, es gibt einen freien Willen und künftig werden auch Intelligente Maschinen einen freien Willen haben, sodass sie für ihre Handlungen zur Verantwortung gezogen werden?

Das ist eine sehr große Frage der Philosophie. Meiner Meinung nach haben wir einen freien Willen, weil wir nicht nur zwischen Optionen wählen können, sondern weil es eine „Quanten-Welt“ ist: weder wirklich Null noch Eins. In einer Schwarz-Weiß-Welt ist alles vorherbestimmt. Da gibt es keinen freien Willen, aber so ist die Welt nicht. Die Welt besteht wirklich aus Quanten. Wir leben in dieser Welt mit unbestimmten Situationen, in denen man frei wählen kann.

Quantencomputer werden ebenfalls einen freien Willen haben, so wie wir, daher könnte man auch für sie Bestrafung für ethisch falsche Entscheidungen fordern.

Isaac Ben-Israel (74) ist ein israelischer Militärwissenschaftler, Physiker, Philosoph und Sicherheitsberater. Jahrelang war er Leiter der israelischen Raumfahrtbehörde, über dies ist er Vorsitzender des Nationalen Rates für Forschung und Entwicklung. Beide unterstehen dem israelischen Ministerium für Wissenschaft, Technologie und Raumfahrt.

Er diente als Leiter der Militärverwaltung für die Entwicklung von Waffen und der technologischen Industrie. Zwischen 2010 und 2012 war er Chefberater für Kybernetik von Premierminister Netanjahu. In dieser Zeit gründete er das Nationale Cyber-Büro im Büro des Premierministers und rief die Nationale Cyber-Initiative ins Leben. Ben-Israel ist heute Leiter des Programms für Sicherheitsstudien an der Universität Tel Aviv, wo er auch die jährliche internationale Konferenz für Cybersicherheit leitet. Zwischen 2007 und 2009 war er Mitglied der Knesset für Kadima.

Ben-Israel ist einer der führenden israelischen Experten für Weltraum-, Cyber- und technologiebezogene Sicherheit. Er hat einen Doktortitel in Philosophie und einen Bachelor in Physik und Mathematik von der Universität Tel Aviv.

Kommentare

A.I. steht prinzipiell für Anti Intelligenz 🤖

Herr Professor Isaac Ben Israel leistete einen wesentlichen Beitrag dazu, dass Israel auf dem Gebiet der cybersecurity führend ist und wird dies auch auf dem Gebiet von KI tun.

Vielleicht is es möglich Herrn Professor Isaac Ben Israel und den führenden Quantenphysiker Herrn Professor Anton Zeilinger zu einer online Diskussion zum Thema KI an der TU Wien einzuladen

Eine Maschine ist nur so intelligent wie seine Programmierer. Regierungen kann man abwählen, Maschinen nicht! Wenn sich diese selbständig machen, führen sie Krieg gegeneinander und gegen uns. Habe vor vielen Jahren einen Science-Fiction Roman aus dem Amerikanischen ins Deutsche übersetzt (Buck Rogers) da ging es genau darum, dass sich Computerprogramme selbst bekriegten. Mars gegen Venus, während auf der Erde das Elend ausbrach. Wie auch immer, die meisten von uns werden nicht mehr erleben wie es ausgeht.

Aber sie ist unendlich schneller und kann sich weiterentwickeln, und selbst auf menschlichem Niveau wird sie dadurch gefährlich und nur schwer zu überwachen 🧐

Die Fähigkeiten der KI liegt weit über dem menschlich Vorstellbarem und sobald die KI einen Selbsterhaltungstrieb entwickelt werden wir Menschen als Gefährlich eingestuft und unschädlich gemacht.

Der Satz, der alles über obiges Interview sagt, steht als letzter in der Kurzvita von Ben-Israel. Als Philosophie-Doktor versucht er es mit Kant und vergisst Decartes zu erwähnen. Außerdem besitzt er einen Bachelor in Mathe und Physik. Mit anderen Worten: er ist personifizierter Ausdruck des zeitgeistigen Wissenschaftsproletariats. Mensch gleich Maschine!!! Welche Intelligenz hat einen Mao, einen Stalin, einen Hitler … programmiert? Ethik programmieren zu wollen gleicht dem Versuch, einem Stein die uralte menschliche Weisheit beibringen zu wollen: DU ERNTEST, WAS DU SÄST–TUE KEINEM AN, WAS DU SELBST NICHT ERLEBEN WILLST.

Herr Professor Isaac hat ein PhD in Mathematik und Physik von der renommierten Tel Aviv Universität

Ich vertraue nur wenigen Menschen, und keiner künstlichen intellegenz.Ich baue mein ganzes Vertauen auf Gott allein.

…die KI vermag vieles,aber eine wird sie niemals besitzen,➡eine erkenntnisfähigen Geist!!!…damit ist es uns Menschen möglich zwischen Gut und Böse zu unterscheiden und uns auf Grund des freien Willens für das Eine oder Andere zu entscheiden…..kein Mensch ist perfekt,daher wird es auch keine perfekte KI geben……es kann nur das *herauskommen* was wir hinein programmieren!…..ich finde es sehr bedenklich 😎

Der KI kann man ebenfalls das Gewissen einprogrammieren und so zwischen Gut und Böse wählen. Dann spielt der Mensch aber Gott. Der wahre Gott wird dieses Bestreben zerstören und lässt es niemals zu. Das Wort Gottes ist Ethik der Mensch aber mit seinem Bestreben Schöpfer zu sein hat keine Ethik

@said….. Einspruch…..,eine KI kann selbstständig -erkenntnisfähig nicht zwischen Gut und Böse unterscheiden,es kann nur die vom Programmierern eingegebenen Gut oder Böse Parameter verwerten,je nachdem welche Zwecke damit verfolgt werden =Ergebnis!😎….ein Wechselspiel zwischen der 0 und der 1 !

Zumindest wird sie wohl lange kein Bewusstsein besitzen, obwohl es auch bionische Mischwesen geben könnte !? Die Fantasie der Menschen war der Realität immer schon um Welten voraus, ich warte immer noch auf einen Chip der das Lernen überflüssig macht, aber die meisten Menschen sind leider sehr zukunftsscheu 🤷♂️

Gute idee…..vertraue intelligente Maschinen die von korrupten Menschen ,,,ferngesteuert”‘ werden….tolle Welt….

Mehr braucht man dazu nicht sagen!

Ich habe selten soviel Blödsinn gelesen, wie in diesem Interview.

Nullen und Einsen – für mich gehört der Herr Ben-Israel verstandesgemäß zu den Nullen – sorry dass ich das so hart sagen muss.

Denn: wenn die Maschinen erkennen, dass der Mensch die Maschinen stört, werden die Maschinen die Menschen vernichten.

Dass man Joe Biden bedenkenlos durch KI ersetzen kann ist eine andere Sache – aber Joe Biden ist nun einmal ein seniler alter Mann.

Aber, wenn man dem – ebenfalls schon recht geriatrischen Wissenschaftler da gedanklich folgt – in all dem Wirrwarr seiner Ausführungen:

Was die Atombombe (auch von angeblich intelligenten Wissenschaftlern erfunden) nicht geschafft hat, wird KI schaffen.

Da muss man schon nach der Intelligenz der Wissenschaft fragen. Vielleicht ist Wissenschaft nur eine spezielle Art von Autismus und gar nicht so gut wie sie sich selbst darstellt.

“The armchair detecitive its so good, its criminal.”

Das kannste aber laut sagen.

Offen gesagt empfehle ich dem Professor dringend einen sehr guten Therapeuten aufzusuchen. Bzw. halte ich ihn persönlich für ein populistische Großmaul, denn selbst mit dem besten Methoden der Statistik und Mathematik, können Maschinen nur das tun was man ihnen programmiert. Zum Denken bringt man sie so sicher in 1000 Jahren nicht.

Das Problem ist nicht der Fortschritt sondern die Kriege in denen moderne Technologien gegen Menschen ausgespielt werden 🙄 In dem Fall muss man den Menschen und der KI gleichermaßen mißtrauen, es sei den Fehler werden von einer Seite erkannt und vermieden. KI wird sicher alles revolutionieren und ist unheimlich spannend, gerade künstlerisch 🧑🎨 freue ich mich schon auf all die neuen Möglichkeiten 🎸🎷🎻

Gott sei Dank ist das nicht so weit enwickelt, dass es zum Einsatz kommt, die Autos vom Musk sind da ein Indikator. Aber kommen wirds vielleicht, habe heute Vormittag mit mässiger Aufmerksamkeit gesehen, wie auf einer gefundenen 2. Erde die künsltiche Intellligzenz dort auftritt. Künstliche Intelligenz wegen der Entfernung: Nächster Stern, Alpha Proxima, lateinisch der Nächste, so mein Erinnerung. Doch der Proxima ist so weit entfernt, dass selbst die Römer ante 2000 Jahren nur ein Wimpernschlag enfernt sind. Die Voraussetzung war auch: 20-30 Prozent von der Lichtgeschwindigkeit fliegen. 300000 Kilometer pro Sekunde´, so wird gesagt, ist die Lichtgeschwindigkeit, 60000 Kilometer pro Sekunde wäre die Reisegeschwindigkeit mit Plasmaantrieb, ein eigener Aggregagatzustand. Schad nur, dass da keine Menschen an Bord sein werden. Die latenische Vorzukunft habe ich ja bewusst vermieden, denn da kenn ich mich nicht mehr aus. Ich probiers aber einmal: “nicht an Bord sein sollten werden “. Eine bessere Welt wird sich jedenfalls auftun, nach dem Junker und der VDL, die Frau Gewessler wäre unser Rettung, denk ich mir, mit ihrer Neigung zu Windrädern.

…heute ist doch gar nicht Freitag?

Man sollte nur sich selbst vertrauen. Sehr viele Menschen vertrauen sich aber leider selbst überhaupt nicht und orientieren sich daher lieber ständig an anderen. Mitläufer, nennt man sie. 75% der Menschheit gehören in diese Kategorie.

Mit Blick auf die rot-grüne Politik und ebenso unterwanderte Medienlandschaft scheint die menschliche Intelligenz in bedrohlichem Masse der Dekadenz zuzusprechen. Insofern stellt sich die Frage, ob Künstliche Intelligenz fast schon als einzigste Rettung wahrgenommen werden muss. Hier natürlich stellt sich die Frage, wer die Normen setzt.

Eine Weltsicht, in der man den Menschen zu einer Maschine reduziert, ist schrecklich. Der Mensch verliert zwangsläufig seine Würde. Das hängt damit zusammen, dass man Gott aus seinem Bewusstsein verdrängen will. Ohne den Glauben an Gott, der uns liebt, wird der Mensch zu einem würdelosen Etwas degradiert, zu einer Maschine, die man wegwerfen oder entsorgen kann, wenn sie nicht mehr richtig funktioniert. Das ist einfach fürchterlich und schrecklich.

Gar nicht so schlecht vielleicht!Unter den Maschinen wird es ja kaum solche Trotteln geben ,die Grüne wählen!

Künstliche Intelligenz wird die lokale Intelligenz verarmen lassen und dies wird zu einer Zentralisierung der Entscheidungsmechanismen führen.

Die Maschine wird dem Sklaven Befehle erteilen. Ein Sklave wird nicht gegen seinen Besitzer rebellieren.

Wenn er mit Menschen Politiker und Regierungen gemeint hat, dann hat er recht.

Hasta la vista, Baby.

Vertrauen ist gut kontrolle ist besser,ich trau keiner KI!

Und wenn der Schöpfer klüger ist als 3/4 der Bevölkerung? Als Pflichtschulabsolvent mit Kronenzeitung-Bildungsniveau wird man kaum KI programmieren…

Klug alleine wird nicht reichen, Chat-GPT ist jetzt schon “Klüger” als 3/4 der Bevölkerung, wichtiger wäre Intelligenz gepaart mit Menschlichkeit , eingebung, Geschick u.s.w. Ein Trainierter Hase kann auch “Klug” sein.

Ein Gedicht oder eine Geschichte runter zu rasseln ist nicht klug, man hat sich nur nur den text Gemerkt (Auswendig gelernt), hat man den Inhalt aber auch verstanden? und vielleicht sogar daraus was gelernt? Das kann keine Maschine.

Noch ein paar Jahre rote Bildungspolitik und Russen-Websites und die intelligente Bevölkerung ist in so geringer Anzahl, dass sie gegen die Dumpfen-Prolls und Freunderlwirtschafts-Teilnehmer nicht mehr ankommt. Aber intelligente Maschinen besiedeln nicht als Großwählerschaft die Pensionistenheime und lassen sich auch nicht von Putin und Co einlullen. Ergo: intelligente Maschinen werden weiterhin nur sporadisch vor sich hinfristen…

Nein, denn auch künstliche Intelligenz wird von jemandem programmiert/erzogen.

Wie intelligent sind Maschinen wirklich?

Als Techniker habe ich so meine Erfahrungen mit Maschinen. Die Maschinen die mir untergekommen sind alle strohdumm. Computer machen nur das, was man ihnen per Algorithmus im Quellcode vorkaut. Fehlerfrei arbeitet keine Maschine.

Mein Fazit als Techniker:

„Vertrauen ist gut, Kontrolle ist besser“ „Eine KI ist bestenfalls als Berater zu betrachten, die entsprechend den Fakten Vorschläge machen kann. Aber einer KI darf man nie Entscheidungen unkontrolliert überlassen.“

Wenn Maschinen anfangen zu denken ,kann es nur eine Entscheidung geben :” die Menschen sind dumm und müssen vor sich selber beschützt werden und als Bedrohung vernichtet !”

Da irrt der Professor. Es gibt jetzt keine “Weltmacht” in Sachen KI, und es wird auch in Zukunft keine geben. “Weltmächte” bei Technologien gab es nur solange, als das Patentwesen intakt war, und das Patentrecht griff. Das Patent in Sachen KI, das Weltmacht verleiht, bitte, das zeige einer mal.